Als Haiku bezeichnet man eine kurze japanische Gedichtform, deren Ideale stille Kraft, Eleganz und Einfachheit auch das gleichnamige Betriebssystem Haiku teilt. Es gehört zu der Gruppe von Freien Betriebssystemen abseits von Linux, die ich mir näher anschauen wollte, da Haiku nicht nur ein freies und quelloffenes Betriebssytem ist, sondern sich durch die geringen Hardwareanforderungen auch als Alternative zu Linux auf älteren Computern eignet.

Die Wurzeln von Haiku reichen in die 90iger Jahre zurück als BeOS sich aufmachte ein Konkurrent zu Microsoft Windows, MacOS und Linux zu werden. Be Inc., die treibende Kraft hinter BeOS, wollte das Beste aus allen drei Welten verbinden und richtete das Betriebssystem auf Privatanwender und den Heimbereich aus. Zentrale Merkmale des jungen BeOS waren ein sauberes und einheitliches Erscheinungsbild des Desktops und die besondere Ausrichtung auf Multimedia-Anwendungen.

Während Linux von seiner Vielseitigkeit und Freier Software profitierte, konnte das kommerzielle und proprietäre BeOS niemals die kritische Masse erreichen, um gewinnbringend am Markt bestehen zu können, weshalb 2001 Be Inc. Konkurs anmelden musste und die Entwicklung an BeOS offiziell eingestellt wurde.

In den Jahren des Bestehens gelang es BeOS jedoch, trotz wechselnder Ausrichtung auf verschiedene Zielgruppen, eine leidenschaftliche Gruppe von Benutzern und Entwicklern für sich zu gewinnen, die schon kurz nach dem Ende von BeOS zuerst OpenBeOS ins Leben riefen und dieses dann später in Haiku umbenannten. Die Idee zum Namen geht auf die Fehlermeldungen des BeOS eigenen Browsers NetPositive zurück, der diese in Form von Haikus darstellte. 2003 folgte dann eigens die Gründung von Haiku Inc., einem gemeinnützigen Verein, der durch öffentliche Spenden die Weiterentwicklung von Haiku bis heute unterstützt.

Wichtigstes Ziel von Haiku ist es BeOS so originalgetreu wie möglich nachzubauen und dabei die Stärken des einheitlichen Desktops in ein Freies Betriebssystem zu überführen. Viel Starthilfe im Sinne von Quellcode gab es leider nicht. Lediglich der Dateimanager und das Startmenü (Deskbar) wurden damals als Freie Software veröffentlicht, weswegen alle anderen Systemkomponenten inklusive Kernel, Dateisystem und Kernanwendungen von Grund auf neu geschrieben werden mussten. Damit ist Haiku ein von den verschiedenen Linuxdistributionen vollständig abgegrenztes und eigenständiges Projekt und unterscheidet sich auch deutlich von anderen BeOS-Nachfolgeprojekten wie z.B. ZevenOS, dass das Erscheinungsbild von BeOS zwar nachbildet, dabei aber beim Unterbau auf Ubuntu und Debian setzt.

Voraussetzungen und Installation

Laut offizieller Dokumentation wird zumindest ein Pentium III mit 256 RAM zur Inbetriebnahme empfohlen. Es gibt aber auch schon positive Berichte über 128 MB bzw. nur 64 MB RAM mit einem Pentium II Rechner. Wie der Zufall so spielt, benutze ich noch ein paar Laptops dieser Leistungsklasse, darunter auch den Dell Inspiron 4000, der für diesen Test wie geschaffen war.

Zum Herunterladen gibt es die zur Zeit aktuelle dritte R1 Alpha-Version von Haiku als empfohlenes "Anyboot-Abbild" und als ISO-Image, das sich auf eine CD schreiben lässt. Die Anyboot-Variante kann man auch auf USB oder, so wie ich es getan habe, direkt auf die Festplatte mit dd schreiben. Für alle, die sich nicht extra einen älteren Laptop zum Testen ersteigern wollen, bietet sich auch das Abbild für eine virtuelle Maschine an. Ein vorgefertigtes Image zum Ausprobieren für Virtualbox lässt sich auch von virtualboxes.org herunterladen, dass bei mir sehr gut funktionierte.

Ein Überblick

In meinem Fall gelang das Installieren von Haiku durch direktes Schreiben des Abbildes auf die Ersatzfestplatte des Laptops. Nach dem Einschalten begrüßt einen zu erst einmal der Bootsplash.

Trotz meiner immerhin 13 Jahre alten Ersatzfestplatte dauerte der gesamte Bootvorgang weniger als 30 Sekunden vom Start bis zum ersten Anblick des Desktops. Einen Loginmanager wie GDM oder KDM gibt es nicht. Haiku selbst ist zur Zeit noch ein Einbenutzer-System, erst später soll es möglich sein auch mehrere Benutzer gleichzeitig am Rechner arbeiten zu lassen. Eine Portierung auf andere Architekturen außer i386 hängt in großem Maße von der Zeit der Entwickler und weiterer Hilfe ab.

Es gab keine großen "Showstopper" während des Tests. Ich hatte Netzwerkzugang, konnte im Internet surfen und Filme abspielen. Die Anwendungen ließen sich flüssig bedienen. Lediglich das Herunterfahren dauerte unverhältnismäßig lange.

Arbeitsfläche

Haiku erinnert an mehr als nur einer Stelle an die Konzepte moderner Desktopumgebungen mit einer reinen Fenstermanager-Lösung. Wer Openbox oder Fluxbox kennt, wird sich schnell an das Rechtsklick-Menü gewöhnen. Anwendungen, Orte und Befehle lassen sich von dort aufrufen und ausführen.

Standardmäßig befindet sich am oberen rechten Rand die Deskbar, praktisch das Startmenü und die Taskleiste für Haiku. Je nach Vorliebe lässt sie sich ganz leicht mit der Maus an jeden gewünschten Bildschirmrand positionieren und so ausrichten, dass die Deskbar dem klassischen Erscheinungsbild entspricht. Fenster lassen sich wie bei Fluxbox gruppieren (Stack&Tile), so dass Webbrowser und Dateimanager in einem Fenster durch Tabs getrennt erscheinen und beide Anwendungen zusammen wie eine einzelne bewegt und verändert werden können. Das alles wird gut in Haikus Dokumentation zur Benutzeroberfläche erklärt.

Anwendungen

Haiku hat auch einige typische Unix-Elemente zu bieten. So gibt es zum Beispiel einen Terminal, indem sich bekannte Unix-Kommandos ausführen lassen, auch wenn nicht jeder gewohnte Befehl verfügbar ist.

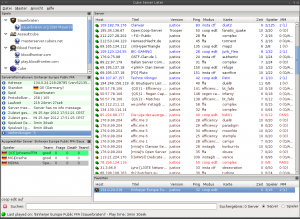

Wie der Screenshot auch zeigt, ist der Ressourcenverbrauch von Haiku gering, so dass 256 MB RAM problemlos zum Ausprobieren ausreichten. Alle Bildschirmaufnahmen ließen sich mit dem Screenshot-Programm dokumentieren. Anschließend konnten sie entweder über den eingehängten USB-Stick oder per SSH auf einen anderen Rechner transferiert werden. Ein SSH-Server ist standardmäßig installiert.

Bei Verwendung von Datenträgern mit einem anderen Dateisystem als Haikus BFS, erscheint eine Warnung, dass man diese nur lesend einhängen sollte. Empfehlenswert, da Haiku noch in einem Alpha-Stadium ist. Ich hatte dennoch keine Probleme die Bilder auf den mit EXT3 formatierten Stick zu schreiben.

In Anlehnung an NetPositive heißt Haikus Browser "Webpositive". Das Web leitet sich von der zu Grunde liegenden WebKit-Engine her, womit Webpositive jetzt wohl der 24. Webkit-Browser ist. 🙂

Das Surfen im Internet gelang auf Anhieb Dank der Möglichkeit eines kabelgebundenen Internetzugangs für meinen Laptop. WLAN funktioniert hingegen zur Zeit nur eingeschränkt unter Haiku. Es wird zwar sowohl unverschlüsseltes als auch nach dem WEP-Standard verschlüsseltes WLAN angeboten, jedoch ist letzteres nicht mehr sicher und da WPA noch nicht möglich ist, ist es auch nicht für den täglichen Gebrauch in unsicheren Netzwerken zu empfehlen.

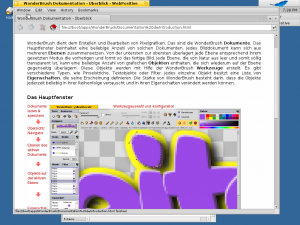

Die Bilder lassen sich z.B. mit Wonderbrush nachbearbeiten, eines der vielen weiteren Programme, die mit Haiku mitgeliefert werden. Der Philosophie entsprechend gibt es für jeden Anwendungsfall ein Programm. Mit den Applikationen lassen sich die wichtigsten Standardaufgaben erledigen, auch wenn ein Audiorecorder oder das TV-Programm noch auf der ToDo-Liste stehen.

Da Haiku sich als freier Nachfolger von BeOS sieht, durften Multimediafähigkeiten nicht fehlen. Der Media-Player nutzt als Backend ffmpeg, kann damit alle gängigen Formate abspielen und ist für die Zukunft erweiterbar. Verschiedene Anwendungen lassen sich wie bekannt auf mehrere Arbeitsflächen verschieben, die sich in Haiku wiederum frei auf dem gesamten Desktop bewegen lassen.

Den Fensterrahmen kann man beliebig mit der Maus verschieben. Fenster lassen sich nur schließen oder mit der Zoom-Funktion automatisch an den Inhalt anpassen. Eine Verkleinern- oder Vergrößernfunktion sucht man vergeblich, ist aber auch unnötig. Insgesamt ließen sich alle Anwendungen ruckelfrei bewegen und in der Größe anpassen.

Dokumentation und Gemeinschaft

Die hier kurz angesprochenen Anwendungen sind nur ein kleiner Teil dessen, was man sonst noch mit Haiku entdecken kann. Der Webauftritt sowie die bisherige Dokumentation laden zum Stöbern ein. Haikus User Guide bietet einen guten Überblick zum Umfang des Projekts. Der meiste Text ist auch in deutscher Sprache verfügbar, auch wenn hier und da Englisch sicher nützlich sein kann. Mehr Bilder zu Haiku finden sich auch bei einem Rundgang mit der Haiku-Tour.

Kommuniziert wird über Mailinglisten, Foren und dem IRC. Regelmäßig finden auch Treffen statt, wie z.B. vor zwei Wochen BeGeistert in Düsseldorf.

Fazit

Die erste Frage, die sich wohl jeder stellt: Warum brauchen wir Haiku? Die Antwort geben die Entwickler in der FAQ als Antwort auf die Frage: "Why not Linux?" Ziel ist es ein kohärentes System zu schaffen, dass sich nicht in einer Vielzahl von Details und Einstellungsmöglichkeiten verliert, sondern schlicht und einfach funktioniert. Eine Aussage, die Haiku mit ReactOS, mit dem Code ausgetauscht wird, teilt.

In der Tat wollen viele Menschen einfach nur einen Computer haben, der funktioniert und für die es keine Rolle spielt, ob ein X-Server für die Darstellung der Grafik verantwortlich ist oder nicht. Haiku bietet mit seiner leichtgewichtigen und einheitlichen Oberfläche ein Argument für diese Benutzer.

Dennoch finden sich unter Linux ebenfalls sehr gute Distributionen, die ein ebenso vollständiges und leichtgewichtiges Desktoperlebnis garantieren. Ich denke, womit Haiku wuchern kann, ist die Tatsache, dass es eben nicht Linux, sondern etwas Eigenständiges ist. Wenn es nur darum ginge, dass immer nur die größten und am weitesten verbreiteten Betriebssysteme eine Chance bekommen sollten, hätte es Linux sicher auch nicht gegeben.

Haiku funktioniert schon sehr gut und verdient meiner Meinung nach mehr als nur einen Blick. Problematisch kann hingegen die Hardwareunterstützung sein. Größtes Problem von Haiku ist weder Konzept noch Technik, sondern Zeit und eine relativ kleine Nutzergemeinde. Vielleicht hilft der Artikel ein wenig positiv in diese Richtung. 😉

Ich kann Haiku für alle empfehlen, die ein leichtgewichtiges Betriebssystem suchen und mit dem jetzigen Alpha-Status umgehen können oder einfach nur das Besondere wollen. Es macht auf jeden Fall mehr Spaß über Haiku (und die japanischen Gedichte) zu lernen als die x-te Linuxdistribution anzutesten, die nur die Desktopumgebung austauscht.