83 Millionen. Diese interessante Zahl veröffentliche vorgestern der IT-Branchenverband Bitkom und bezifferte damit die potentielle Anzahl von in deutschen Haushalten herumliegenden Althandys, wie heise.de berichtet. Grob geschätzt hat also jeder Deutsche irgendwo noch ein Mobiltelefon zu Hause herumliegen, dass er womöglich gar nicht mehr benutzt.

Für mich rief diese Zahl Erinnerungen an meine vor einiger Zeit veröffentlichten Ergebnisse zum Energieverbrauch meiner Computer wach. Wie viele ältere PCs, Laptops und Netbooks wird es wohl in Deutschland noch geben und wie viel Energie wurde in ihre Herstellung investiert, was wird verbraucht und vor allem was lässt sich mit all der Elektronik noch anstellen?

Ich gebe mich nicht der Illusion hin zu glauben, dass sich in naher Zukunft etwas an diesem IT-Trend ändern wird. Es ist wohl heute schon eher der Regelfall mehrere Handys, Smartphones, Tablets, Laptops und normale PCs gleichzeitig zu besitzen. Auf einen allgemeinen Willen, der Fortschritt und Nutzen sowie wirtschaftliche als auch ökologische Vernunft zusammenführt, müssen wir wohl noch eine Weile warten.

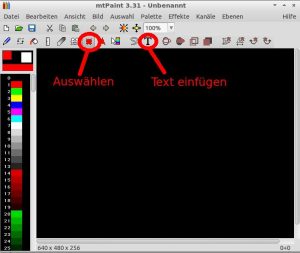

Bevor ich mich nun als Moralapostel aufspiele, der nicht wenige dieser IT-Goodies selbst besitzt, ist hier einfach mal ein Überblick über meinen Rechenpark und die Freie Software, die dort zum Einsatz kommt, was man damit noch machen kann und warum es sich lohnt an gebrauchter Hardware nicht nur festzuhalten, sondern sie einfach weiterhin wie einen neuen Rechner zu benutzen.

Core Duo

Wenn man einen klassischen Desktop-PC mit einem 2,8 GHz Dual-Core-Prozessor betreibt, stellt man schnell fest, dass es kaum eine Anwendung gibt, die man damit nicht zum Laufen bringen kann. Dieser PC gehört schon lange wieder zur Low-End Kategorie, aber ernsthaft, mir ist noch keine Applikation untergekommen, die hier drauf nicht funktionieren würde.

Anfang des letzten Jahres habe ich mich entschieden ein Multiboot-System aufzusetzen, wo heute noch Ubuntu, Debian Testing und Debian Sid parallel installiert sind. Die Vorteile überwiegen für mich eindeutig. Auf einer weiteren Partition teste ich gerne auch andere Distributionen oder benutze sie für meine Experimente zum Thema Softwareentwicklung.

Ich denke, ich habe damit eine Menge neue und gute Erfahrungen gemacht und das System erfüllt alle meine Erwartungen. Insbesondere Debian Testing hat mich überzeugt, weil es dieses Jahr bis auf meine Nvidia-Probleme zuverlässig und mit aktueller Software funktionierte. Trotz des für die Debianentwickler aufwändigen Wechsels von Gnome 2 zu Gnome 3 geriet Testing nie ins stottern. Für einen klassischen Arbeits- und Multimedia-PC hat sich Debian auf jeden Fall bewährt und die Vorurteile, dass es mit Debian viel schwieriger sei ein solches Setup einzurichten und zu pflegen, konnte ich für mich nicht bestätigen.

Auch ein leichtgewichtiges Spielesystem macht sich bezahlt, dass nicht nur eine gute Performance liefert, sondern auch eine praktische und gefahrlose Trennung zwischen wichtigen und optionalen Anwendungen ermöglicht.

Ubuntu habe ich letztes Jahr etwas vernachlässigt. Das liegt weniger daran, dass mir Gnome 3 gegenüber Unity besser gefällt, als dass ich bisher wenig Zeit für mein Projekt, Ubuntu als Videoschnittplatz zu benutzen, gefunden habe. Doch aufgeschoben ist nicht aufgehoben.

Seit 2008 benutze ich diesen mittlerweile 10 Jahre alten Laptop. Als Betriebssystem stand Debian Sid mit Openbox als Fenstermanager eindeutig im Fokus. Trotz des hohen Alters sorgen beide dafür, dass sich Anwendungen flüssig bedienen lassen. Bis zu diesem kleinen Missgeschick hat er mich auch oft unterwegs begleitet. Zur Zeit dient er als Couch-Laptop, wer sich unter dem Begriff etwas vorstellen kann. 🙂

Internetsurfen, Mails abrufen oder Feeds lesen lässt sich natürlich auch mit einem älteren Laptop erledigen. Wozu also immer den wesentlich energiehungrigeren Core Duo bemühen?

Sicherlich ist er auch weiterhin perfekt um als Testrechner für die brandneuste Entwicklung mit Debian zu dienen. Es macht einfach Spaß mit Sid zu arbeiten, auch wenn oder gerade deswegen, manchmal etwas nicht so funktioniert wie es sollte.

Als Zweitsystem dient mir Arch Linux, womit ich interessante neue Ideen kennenlerne und ausprobiere. Arch Linux gelingt es an manchen Stellen wie z.B. der Paketverwaltung noch etwas reaktionsfreudiger zu sein.

Ansonsten dürfen sowohl KolibriOS als auch der Plop Bootmanager auf Grund ihrer Vielseitigkeit und des schieren "WoW-Faktors" auf diesem Laptop nicht fehlen.

Bevor ich mit dieser Einteilung zufrieden war, habe ich noch verschiedene Distributionen mit dem Inspiron ausprobiert, darunter unter anderem Crunchbang und Linux Mint Debian.

Erst vor wenigen Monaten habe ich einen Thinkpad als mobilen Ersatz für den Inspiron 4000 erworben, den ich dann am liebsten neben MacBook Pro Besitzern aufbaue.

Neben seinem Gastauftritt auf einem Weihnachtsmarkt als Jukebox, ist er vor allem mit einer Menge nützlicher Konsolenanwendungen bestückt, die von Debian Stable geliefert werden. Benötige ich eine grafische Oberfläche, komme ich mittlerweile mit dwm sehr gut zurecht, das zum einen ressourcensparend ist und sich zum anderen bequem über die Tastatur bedienen lässt.

Als Alternative hat sich das parallel installierte ConnochaetOS etabliert, dass durch eine gute Vorauswahl von leichtgewichtiger Software und den effizienten Unterbau von Arch Linux besticht. Mit Hilfe von Partimage tausche ich manchmal dieses Zweitsystem aus.

Auch Slitaz hat sich nicht schlecht geschlagen und beeindruckt vor allem durch seinen äußerst geringen Verbrauch an Festplattenspeicher und sehr effiziente Systemprogramme. KolibriOS und der Plop Bootmanager dürfen ebenfalls nicht fehlen.

Zusammengenommen vermisse ich nicht besonders viel mit dem Thinkpad, sieht man mal von der Fähigkeit ab h264 Videos ruckelfrei abspielen zu können. Hier muss die Pentium II CPU einfach passen.

Toshiba ist mit diesem kompakten Subnotebook 1999 schon ein kleines Kunststück gelungen. Portabilität ist sicher seine große Stärke. Umso merkwürdiger scheint es da zu sein, dass ich dieses Geschenk zur Zeit hauptsächlich als kleinen Heimserver und Testplatz für Fenstermanager und Konsolenanwendungen benutze. Viel zu klagen hatte ich 2011 nicht, denn dank Debian Stable läuft der Rechner rund und stabil. Durch die geringe Größe nimmt der Laptop nicht besonders viel Platz weg und trotz des kleineren 64 MB Arbeitsspeichers, sind seine anderen Systemspezifikationen besser als die des Thinkpad. Das macht ihn leistungsfähig genug, um alle meine privaten Serveransprüche zu erfüllen.

Dieser 15 Jahre alte Laptop ist mit Sicherheit eine Herausforderung. Das Problem liegt weniger an der 1,4 GB großen Festplatte oder dem Pentium I Prozessor. Hätte dieser Toshiba etwas mehr RAM, ich könnte sehr wahrscheinlich von den gleichen Ergebnissen wie bei den anderen Computern erzählen. Die Herausforderung besteht tatsächlich darin ein geeignetes Betriebssystem zu finden, welches sowohl die Hardwareanforderungen von 16 MB RAM erfüllt und zum anderen zeitgemäße Software zur Verfügung stellt.

Den besten Kompromiss aus Geschwindigkeit, Bedienbarkeit und Softwareauswahl liefert hier zur Zeit Slitaz. Es ist eine der wenigen Distributionen, deren Installationsmedien selbst bei so wenig RAM noch funktionieren und die, typische Linuxkenntnisse vorausgesetzt, keine großen Hürden für den Anwender darstellen. Idealerweise bringt Slitaz mit tazpkg einen äußerst reaktionsfreudigen Paketmanager mit, mit dessen Hilfe das Installieren von Software ein Kinderspiel ist.

Zur Zeit eignen sich insbesondere Konsolenanwendungen für einen effizienten Einsatz und auch der Betrieb als Torrent-Sklave oder Jukebox ist möglich. Für die Zukunft sollte man sich auch Do-it-yourself-Distributionen wie CRUX merken, mit denen sich ein maßgeschneidertes und sehr effizientes System erstellen lässt, dass aber mehr Wissen des Anwenders voraussetzt.

Schon heute gibt KolibriOS mit einer grafischen Oberfläche ein gutes Bild auf dem Satellite 220CS ab, auch wenn sich damit nicht jedes Benutzerszenario abdecken lässt. Ebenfalls beeindruckend ist FreeDOS, das eine ideale Wahl für Rechner Anfang und Mitte der 90iger Jahre ist und mit dem sich mehr erreichen lässt als nur Spiele aus der damaligen Zeit zu spielen.

Fazit

Mein Blog gäbe es in dieser Form nicht, wenn es selbstverständlich wäre, ältere Hardware weiterhin mit Freier Software weiterzuverwenden. Menschen, die so etwas tun, etikettiert man gerne mit negativ konnotierten Begriffen wie nostalgisch, antiquiert und rückwärts gewandt. Ich kann nicht garantieren, dass die in diesem Blog beschriebenen Wege für jeden das Richtige sind, ich sage nur, sie funktionieren für mich.

Alle meine privaten Anwendungsfälle werden mit den alten Rechnern abgedeckt. Es lohnt schon allein aus informativen Gründen, sich näher mit der Thematik rund um Freie Software und ältere Rechner zu beschäftigen. Man muss nur offen für Neues sein und immer an die Vielzahl von Verwendungsmöglichkeiten zurückdenken.

Und irgendwann kommt der Zeitpunkt, wann sich das alles mit der aktuellen Hardware von heute wiederholen wird.