Viele auf Debian basierende Distributionen werben damit, dass proprietäre Treiber und Codecs schon automatisch nach der Installation funktionieren, alle wichtigen Anwendungen vorhanden sind und Compiz aus allen Ecken blinkt.

Doch dieses "Ich-habe-alles-was-ich-brauche" Gefühl lässt sich auch mit dem Original in wenigen Schritten nach einer Installation erreichen. Denn wer sagt denn, was eigentlich die "wichtigen" Programme sind und wer braucht wirklich jeden proprietären Codec um einen Film abzuspielen? Manchmal genügt es auch mit weniger als der kompletten Gnome Desktopumgebung Emails abzurufen oder im Internet zu surfen.

Ich mache einfach bei meinem letzten Beitrag weiter und zeige, welche Programme und Einstellungen mir nach einer minimalen Debian-Netzinstallation mit dem Paket gnome-core noch wichtig sind.

Im folgenden nutze ich aptitude zum Installieren, aber jeder ist frei auch auf apt-get oder das grafische Synaptic zum Installieren zurückzugreifen. Solange mein PC noch keine Befehle per Stimme entgegen nimmt, ist das für mich erst einmal der schnellste Weg zum Konfigurieren. 😉

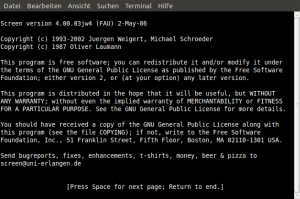

Meine /etc/apt/sources.list:

deb http://ftp.de.debian.org/debian testing main contrib non-free

deb-src http://ftp.de.debian.org/debian/ testing main

deb http://www.deb-multimedia.org testing main non-free

Nvidia Treiber

Am einfachsten ist es das vorgefertigte Modul zu installieren, welches mit dem Testing Kernel, momentan noch 2.6.32, mitgeliefert wird.

aptitude install nvidia-kernel${VERSION}-$(uname -r)

aptitude install nvidia-glx${VERSION}

aptitude install nvidia-xconfig

aptitude install nvidia-settings

Mit dem Programm nvidia-xconfig lässt sich eine neue Konfigurationsdatei für den X Server automatisch erzeugen. Bei mir genügte es nvidia-xconfig im Terminal auszuführen und X danach mit invoke-rc.d gdm3 restart in der Konsole neu zu starten. Unter Systemverwaltung lassen sich dann mit Hilfe von nvidia-settings weitere Einstellungen vornehmen.

Ergänzung 01.10.2011: Debian Testing entwickelt sich fortlaufend weiter. Am leichtesten lassen sich die Treiber nun mit dem Paket nvidia-kernel-dkms installieren. Der Rest gilt auch weiterhin.

Es gibt noch drei andere Möglichkeiten den Nvidia Treiber zu installieren, doch ich denke, es ist am einfachsten das vorgefertigte Modul zu nutzen, welches sich auf die gleiche Weise auch mit neueren Kerneln verwalten lässt.

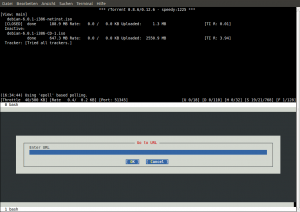

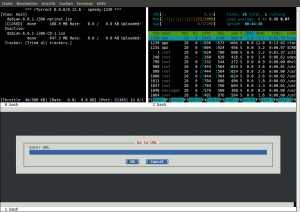

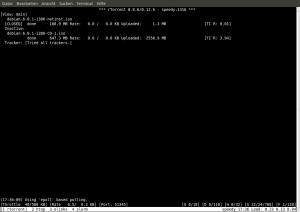

Multimedia

Viel Aufhebens wird oft um fehlende Codecs zum Abspielen von Filmen oder Audiodateien gemacht. Doch wie schwierig oder notwendig ist es diese nach zu installieren? Wer deb-multimedia.org in seinen Paketquellen eingetragen hat, hat dieses Problem oft schon mit der Installation von mplayer gelöst und vlc ist sicher auch eine gute Alternative. Ist man tatsächlich auf Quicktime, RealVideo, Windows Media 9 oder Flash angewiesen, muss nur noch w32codecs und flashplugin-nonfree installiert werden.

Gnome anpassen

Ich ziehe bei Debian eine minimale gnome-core Installation der kompletten Desktopumgebung vor und gehe lieber vom Kleinen zum Großen. Ich brauchte zusätzlich nur noch diese Pakete:

system-config-printer (Drucker einrichten mit Cups und Gnome)

seahorse und seahorse-plugins (Verschlüsselung mit GnuPG einrichten und Nautilus um diese Funktion erweitern)

gnome-system-tools (Grafische Werkzeuge zur Administration von Linuxsystemen)

Desktop gestalten

Das ist der Punkt, der oft am längsten dauert, meist nur aus dem Grund, weil es schwer fällt sich zu entscheiden. Der Standarddesktop von Debian und Gnome ist, neutral ausgedrückt, ziemlich schlicht. Am besten würden mir mehrere Debian-Pakete gefallen, welche einfach die am besten bewerteten Gtk2-Themen, Icons und Hintergründe installieren und man danach nur noch aus diesen wählen muss.

Linux Mint Debian hat sich die Mühe gemacht ein eigenes Design zu stemmen, doch warum in die Ferne schweifen, wenn es gute Designs z.B. schon auf gnome-look.org gibt.

Meine jetziges Design setzt sich so zusammen:

gtk2 Thema: Orta

Icons: Faenza

Hintergrund: Wechselt zu häufig, dank dem großen Angebot.

Compiz und AWN Dock installieren

aptitude install compiz compiz-gnome compizconfig-settings-manager avant-window-navigator

Danach lässt sich Compiz wie gewohnt unter System->Einstellungen verwalten. Im Gegensatz zu Ubuntu gibt es zwar kein Extramenü unter Einstellungen->Erscheinungsbild, um ein paar Voreinstellungen für Compiz zu aktivieren. Die wichtigsten Einstellungen lassen sich aber auch bequem mit dem CompizConfig-Einstellungs-Manager vornehmen.

Der Rest

Das waren für mich die wichtigsten Punkte nach der Debian Netzinstallation mit gnome-core. Der Rest beschränkt sich auf das Installieren von Einzelanwendungen. Ob man lieber Gimp, Transmission, Gwibber, Shotwell usw. installieren möchte oder nicht, ist wie das Design Geschmackssache.

Mir fällt im Moment nichts mehr ein, was ich gegenüber einer Ubuntu-Installation vermisst habe. Es funktionierte einfach. Das ist sicherlich nicht für jeden Linuxbeginner der Königsweg. Für mich war es aber eine gute Erinnerung, dass Debian zwar Kanten und Ecken hat, diese sich aber leichter abrunden lassen als andere oft behaupten.